Une croissance rapide, portée par l’innovation

L’évolution de la consommation énergétique des modèles d’IA

Depuis les années 1980, les modèles d’IA ont progressivement quitté les laboratoires pour trouver des applications dans le monde réel. Au fil du temps, la taille des modèles d’IA est passée de quelques dizaines de paramètres à plusieurs centaines de milliards.

Cette évolution de complexité (et de performance) repose sur trois facteurs :

- l'amélioration continue des algorithmes

- l'accès à d'immenses volumes de données

- des infrastructures de stockage et de calcul de plus en plus puissantes

Ce sont ces derniers facteurs, les infrastructures de stockage et de calcul, qui représentent le principal coût énergétique de l'intelligence artificielle

Aujourd’hui, ces modèles ne représentent qu’une faible part de l’impact du numérique sur les ressources planétaires. Toutefois, l’engouement du grand public pour l’IA générative pourrait, dans les années à venir, lui donner une part significative dans la consommation énergétique mondiale.

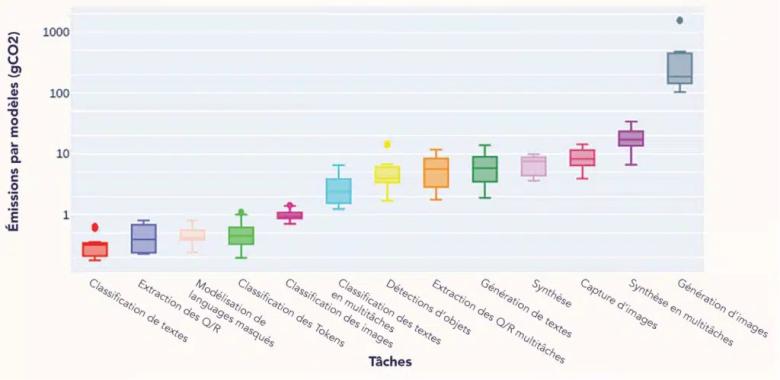

Les tâches examinées dans notre étude et la quantité moyenne d’émissions de carbone qu’elles produisent (en g de CO2eq) pour 1 000 requêtes.

Polytechnique Insights

Le piège des “coûts masqués”

On distingue généralement 2 grandes étapes dans la vie d’un modèle d’intelligence artificielle :

- La construction : c’est l’étape la plus énergivore, car elle comprend la phase d’expérimentation (choix d’architecture, sélection des données d’entrainement, etc.) ainsi que la phase d’apprentissage, durant laquelle, on va enseigner au modèle à répéter la tâche voulue.

- L’utilisation : aussi appelé « l’inférence », c’est une étape peu consommatrice comparativement à la phase de construction, puisqu’il s’agit ici de demander au modèle de réaliser la tâche pour laquelle il a été entrainé.

Si une part importante est consommée lors de la phase de construction, la multiplication des inférences peut fortement l’augmenter le côut énergétique des modèles d’IA.

En effet, l'interaction avec un chatbot peut sembler simple et instantanée, cependant, cela entraine une succession d’inférences dont l’utilisateur n’a pas conscience. Pourtant, à chaque interaction, ça ajoute un coût supplémentaire au bilan énergétique du modèle.

Ainsi, il est difficile de déterminer le coût réel d’un modèle d’IA. Cependant, d’après l’Agence internationale de l’énergie, les interactions avec des IA comme ChatGPT pourraient consommer 10 fois plus d’électricité qu’une recherche Google classique.

Frugalité : des modèles plus légers pour des usages ciblés

L’engouement actuel pour l’IA générative, et plus particulièrement les Large Language Models (LLM), fait oublier que la majorité des modèles d'IA sont "frugaux".

On parle d'un modèle d’IA "frugal" pour désigner un système conçu pour accomplir une tâche avec un minimum de ressources, en optimisant la consommation d’énergie, la puissance de calcul et parfois même la quantité de données utilisée.

Par exemple, un smartphone est capable de localiser en temps réel un visage dans une image vidéo. A l’inverse, un ordinateur de bureau peut avoir des difficultés à faire fonctionner même un “petit” LLM.

Cela amène les chercheurs et les industriels à se poser une question simple, mais essentielle : Est-ce que nos outils d’analyse ont réellement besoin de s’appuyer sur des modèles aussi énergivores que les LLM ?

Vers une IA plus responsable

Les outils d’IA générative impressionnent par leurs performances et leur simplicité d’usage. Toutefois, il est primordial se poser la question du coût environnemental de cette solution vis à vis des bénéfices qu’elle peut apporter.

Des outils comme EcoLogits Calculator - a Hugging Face Space by genai-impact, The Coalition - Coalition for Sustainable AI ou AI Energy Score, permettent d’estimer cette consommation. Ce sont des initiatives qui veillent aussi à fournir des indicateurs adaptés, et à convaincre les concepteurs à être transparents sur leurs coûts.

Car la frugalité, ne signifie pas renoncer à la performance, elle implique d’adapter la puissance à l’usage réel et à éviter les excès inutiles tout en intégrant la notion de durabilité dès la phase de construction des modèles d’IA.

Comme nous l’avons évoqué dans un précèdent article, certains modèles d’IA peuvent aussi devenir un véritable outil d’aide à la décision (lien vers l’article à ajouter lorsqu'il sera publié), notamment dans le domaine des géosciences.

Alors pour faire mentir les Shadoks, et leur fameuse devise « pourquoi faire simple quand on peut faire compliqué ? » on peut aussi choisir de faire simple, surtout quand c’est suffisant !

Actualité écrite en collaboration avec les chercheurs du BRGM

N.B. L’axe des y est en échelle logarithmique